Neue Technologien, insbesondere die künstliche Intelligenz, verändern die Art der kreativen Prozesse drastisch. Computer spielen bei kreativen Tätigkeiten wie Musik, Architektur, bildende Kunst und Wissenschaft eine sehr wichtige Rolle. In der Tat ist der Computer bereits eine Leinwand, ein Pinsel, ein Musikinstrument usw. Wir sind jedoch der Meinung, dass wir uns ehrgeizigere Ziele für die Beziehung zwischen Computern und Kreativität setzen müssen. Anstatt den Computer nur als ein Werkzeug zu sehen, das den menschlichen Schöpfer unterstützt, könnten wir ihn als eine eigenständige kreative Einheit betrachten. Diese Sichtweise hat einen neuen Teilbereich der künstlichen Intelligenz hervorgebracht, der Computational Creativity genannt wird. Dieser Artikel befasst sich mit der Frage, ob es möglich ist, Computerkreativität zu erreichen, und zeigt einige Beispiele von Computerprogrammen, die in der Lage sind, Aspekte kreativen künstlerischen Verhaltens zu replizieren. Abschließend werden einige Überlegungen zum jüngsten Trend der Demokratisierung der Kreativität durch die Unterstützung und Erweiterung der menschlichen Kreativität angestellt.

Computerkreativität

Computerkreativität ist das Studium der Entwicklung von Software, die ein Verhalten zeigt, das bei Menschen als kreativ gelten würde. Solche kreative Software kann für autonome kreative Aufgaben verwendet werden, wie das Erfinden mathematischer Theorien, das Schreiben von Gedichten, das Malen von Bildern und das Komponieren von Musik. Computergestützte Kreativitätsstudien ermöglichen es uns jedoch auch, die menschliche Kreativität zu verstehen und Programme zu entwickeln, die von kreativen Menschen genutzt werden können, wobei die Software eher als kreativer Mitarbeiter denn als bloßes Werkzeug fungiert. In der Vergangenheit war es für die Gesellschaft schwierig, sich mit Maschinen zu arrangieren, die angeblich intelligent sind, und noch schwieriger, zuzugeben, dass sie kreativ sein könnten. Selbst in der Informatik ist man immer noch skeptisch gegenüber dem kreativen Potenzial von Software. Eine typische Aussage von Gegnern der Computerkreativität lautet: „Künstlerische Techniken zu simulieren bedeutet auch, menschliches Denken und Argumentieren zu simulieren, insbesondere kreatives Denken. Das ist mit Algorithmen oder Informationsverarbeitungssystemen nicht möglich“. Dem können wir nur zustimmen. Wie aus den Beispielen in diesem Papier hoffentlich hervorgeht, ist Kreativität keine mystische Gabe, die sich einer wissenschaftlichen Untersuchung entzieht, sondern etwas, das erforscht, simuliert und zum Wohle der Gesellschaft nutzbar gemacht werden kann. Und während die Gesellschaft vielleicht noch aufholen muss, ist die Computerkreativität als Disziplin erwachsen geworden. Diese Reife zeigt sich in der Menge der Aktivitäten, die in den letzten Jahren im Bereich der Computerkreativität unternommen wurden, in der Raffinesse der kreativen Software, die wir entwickeln, im kulturellen Wert der Artefakte, die von unserer Software produziert werden, und vor allem in dem Konsens, den wir zu allgemeinen Fragen der Computerkreativität finden.

Computerkreativität ist ein sehr lebendiger Themenbereich, in dem viele Fragen noch offen sind. So greifen beispielsweise viele Menschen immer noch auf den Turing-Test (Turing, 1950) zurück, um den Wert der von ihrer Software erzeugten Artefakte abzuschätzen. Das heißt, wenn eine bestimmte Anzahl von Personen nicht feststellen kann, welche Artefakte vom Computer und welche vom Menschen erzeugt wurden, dann ist die Software gut. Andere meinen, dass der Turing-Test für kreative Software ungeeignet ist. Man muss sich die Frage stellen: „Würden die Menschen bei vollständiger Offenlegung die von einem Computer erzeugten Artefakte genauso hoch einschätzen wie die von Menschen erzeugten?“ In einigen Bereichen könnte die Antwort ja lauten: Ein Witz ist zum Beispiel auch dann lustig, wenn er von einem Computer produziert wurde. In anderen Bereichen, wie z. B. der bildenden Kunst, ist die Antwort jedoch sehr wahrscheinlich nein. Dies unterstreicht die Tatsache, dass bei der Bewertung von Kunstwerken der Produktionsprozess und nicht nur das Ergebnis berücksichtigt wird. Man könnte also argumentieren, dass solche Turing-Tests den Computern im Grunde genommen den Garaus machen.

Die Entwicklung kreativer Software stellt sowohl eine technische als auch eine soziale Herausforderung dar. Um weiterzukommen, müssen wir die Tatsache akzeptieren, dass Computer keine Menschen sind. Wir sollten laut und stolz auf die Artefakte sein, die unsere Software hervorbringt. Wir sollten die Raffinesse der Techniken der künstlichen Intelligenz (KI) feiern, die wir eingesetzt haben, um die Software mit kreativem Verhalten auszustatten. Und wir sollten der breiten Öffentlichkeit helfen, den Wert dieser Computerkreationen zu schätzen, indem wir die Methoden beschreiben, mit denen die Software sie erzeugt.

Kreativität erscheint geheimnisvoll, denn wenn wir kreative Ideen haben, ist es sehr schwierig zu erklären, wie wir sie bekommen haben, und wir sprechen oft von vagen Begriffen wie „Inspiration“ und „Intuition“, wenn wir versuchen, Kreativität zu erklären. Die Tatsache, dass wir uns nicht bewusst sind, wie sich eine kreative Idee manifestiert, bedeutet nicht unbedingt, dass es keine wissenschaftliche Erklärung geben kann. Auch bei anderen Tätigkeiten wie Sprachverständnis, Mustererkennung usw. ist uns nicht bewusst, wie wir sie ausführen, aber wir verfügen über immer bessere KI-Techniken, die solche Tätigkeiten nachahmen können.

Da nichts aus der Leere entstehen kann, müssen wir verstehen, dass jedem schöpferischen Werk oder jeder schöpferischen Idee immer ein historisch-kulturelles Schema vorausgeht; es ist eine Frucht des kulturellen Erbes und der gelebten Erfahrungen. Wie Margaret Boden in ihrem Buch Artificial Intelligence and Natural Man (Boden, 1987) feststellt:

Wahrscheinlich sind die neuen Gedanken, die im Geist entstehen, nicht völlig neu, denn sie haben ihren Keim in Repräsentationen, die sich bereits im Geist befinden. Anders ausgedrückt: Hinter jeder kreativen Idee steckt der Keim unserer Kultur, all unser Wissen und unsere Erfahrung. Je größer das Wissen und die Erfahrung sind, desto größer ist die Möglichkeit, einen undenkbaren Zusammenhang zu finden, der zu einer kreativen Idee führt. Wenn wir Kreativität als das Ergebnis der Herstellung neuer Beziehungen zwischen bereits vorhandenem Wissen verstehen, dann ist die Fähigkeit, kreativ zu sein, umso größer, je mehr Vorwissen man hat.

Mit diesem Verständnis im Hinterkopf lautet eine operationelle und weithin akzeptierte Definition von Kreativität: „Eine kreative Idee ist eine neuartige und wertvolle Kombination bekannter Ideen.“ Mit anderen Worten: Physikalische Gesetze, Theoreme und Musikstücke können aus einer endlichen Menge vorhandener Elemente generiert werden, und daher ist Kreativität eine fortgeschrittene Form der Problemlösung, die u. a. Gedächtnis, Analogie, Lernen und logisches Denken unter Zwang umfasst und daher mit Hilfe von Computern nachgebildet werden kann.

Dieser Artikel befasst sich mit der Frage, ob es möglich ist, Kreativität mit Hilfe von Computern zu erreichen, indem einige Beispiele von Computerprogrammen vorgestellt werden, die in der Lage sind, einige Aspekte kreativen Verhaltens nachzubilden. Aus Platzgründen konnten wir andere interessante Anwendungsbereiche wie Geschichtenerzählen (Gervás, 2009), Poesie (Montfort et al., 2014), Wissenschaft (Langley et al., 1987) oder sogar Humor (Ritchie, 2009) nicht berücksichtigen. Aus diesem Grund werden in diesem Beitrag mit unterschiedlichem Detaillierungsgrad repräsentative Ergebnisse einiger Leistungen in den Bereichen Musik und bildende Kunst behandelt. Der Grund für die Fokussierung auf diese künstlerischen Bereiche liegt darin, dass sie bei weitem am aktivsten sind und die erzielten Ergebnisse am beeindruckendsten sind. Der Beitrag endet mit einigen Überlegungen zum jüngsten Trend der Demokratisierung der Kreativität durch die Unterstützung und Erweiterung der menschlichen Kreativität.

Als weiterführende Lektüre zum Thema Computerkreativität im Allgemeinen empfehle ich die Sonderausgabe des AI Magazine über Computerkreativität (Colton et al., 2009) sowie die Bücher von Boden (1991, 1994, 2009), Dartnall (1994), Partridge & Rowe (1994), Bentley & Corne (2002) und McCormack & d’Inverno (2012).

Computerkreativität in der Musik

Künstliche Intelligenz hat in der Geschichte der Computermusik fast seit ihren Anfängen in den 1950er Jahren eine entscheidende Rolle gespielt. Bis vor kurzem lag der Schwerpunkt jedoch auf Kompositions- und Improvisationssystemen, während der expressiven Aufführung nur wenig Aufmerksamkeit geschenkt wurde. In diesem Abschnitt wird eine Auswahl bedeutender Errungenschaften bei KI-Ansätzen zur Musikkomposition, Musikaufführung und Improvisation vorgestellt, wobei der Schwerpunkt auf der Aufführung ausdrucksstarker Musik liegt.

Künstliche Intelligenz und Komposition

Die Arbeit von Hiller und Isaacson (1958) am ILLIAC-Computer ist die bekannteste Pionierarbeit im Bereich der Computermusik. Ihr Hauptergebnis ist die Illiac Suite, ein Streichquartett, das nach dem Problemlösungsansatz „Generieren und Testen“ komponiert wurde. Das Programm generierte die Noten pseudozufällig mit Hilfe von Markov-Ketten. Die erzeugten Noten wurden anschließend mit Hilfe heuristischer Kompositionsregeln der klassischen Harmonie und des Kontrapunkts getestet. Nur die Noten, die den Regeln entsprachen, wurden beibehalten. Wenn keine der erzeugten Noten den Regeln entsprach, wurde durch ein einfaches Backtracking-Verfahren die gesamte Komposition bis zu diesem Punkt gelöscht, und ein neuer Zyklus wurde gestartet. Die Ziele von Hiller und Isaacson schlossen alles aus, was mit Ausdruckskraft und emotionalem Inhalt zu tun hatte. In einem Interview (Schwanauer und Levitt, 1993, S. 21) sagten Hiller und Isaacson, dass zunächst einfachere Probleme gelöst werden müssten, bevor man sich mit der Frage der Ausdruckskraft befassen könne. Wir glauben, dass dies in den 1950er Jahren eine sehr richtige Feststellung war. Nach dieser bahnbrechenden Arbeit stützten sich viele andere Forscher bei ihren Computerkompositionen auf Markov-Wahrscheinlichkeitsübergänge, jedoch ebenfalls mit eher begrenztem Erfolg, wenn man die melodische Qualität betrachtet. In der Tat sind Methoden, die sich zu sehr auf Markov-Prozesse stützen, nicht ausreichend informiert, um konsistent hochwertige Musik zu produzieren.

Allerdings stützen sich nicht alle frühen Arbeiten zur Komposition auf probabilistische Ansätze. Ein gutes Beispiel ist die Arbeit von Moorer (1972) über die Erzeugung tonaler Melodien. Moorers Programm generierte einfache Melodien zusammen mit den zugrundeliegenden harmonischen Progressionen mit einfachen internen Wiederholungsmustern von Noten. Dieser Ansatz beruht auf der Simulation menschlicher Kompositionsprozesse unter Verwendung heuristischer Techniken und nicht auf markovschen Wahrscheinlichkeitsketten. Levitt (1993) vermied ebenfalls die Verwendung von Wahrscheinlichkeiten im Kompositionsprozess. Er argumentiert, dass „der Zufall die musikalischen Zwänge, die zur Darstellung einfacher musikalischer Strukturen erforderlich sind, eher verschleiert als offenbart“. Seine Arbeit basiert auf Beschreibungen von Musikstilen auf der Grundlage von Beschränkungen. Er entwickelte eine Beschreibungssprache, die es ermöglicht, musikalisch sinnvolle Transformationen von Eingaben wie Akkordfolgen und melodischen Linien durch eine Reihe von Zwangsbedingungen auszudrücken, die er „Stilvorlagen“ nennt. Er wandte diesen Ansatz an, um eine Simulation eines traditionellen Jazz-Walking-Bassisten sowie eine Simulation eines zweihändigen Ragtime-Pianos zu beschreiben.

Die frühen Systeme von Hiller-Isaacson und Moorer basierten beide ebenfalls auf heuristischen Ansätzen. Das vielleicht authentischste Beispiel für den frühen Einsatz von KI-Techniken ist jedoch die Arbeit von Rader (1974). Rader verwendete regelbasierte KI-Programmierung in seinem Generator für einen musikalischen Reigen (einen Kreiskanon wie „Frère Jacques“). Die Erzeugung der Melodie und der Harmonie basierte auf Regeln, die beschreiben, wie Noten oder Akkorde zusammengesetzt werden können. Die interessanteste KI-Komponente dieses Systems sind die Anwendbarkeitsregeln, die die Anwendbarkeit der Regeln für die Melodie- und Akkorderzeugung bestimmen, und die Gewichtungsregeln, die die Wahrscheinlichkeit der Anwendung einer anwendbaren Regel mit Hilfe eines Gewichts angeben. Wir können bereits in dieser frühen Arbeit die Verwendung von Metawissen erkennen.

KI-Pioniere und Computerkreativität

Auch KI-Pioniere wie Herbert Simon oder Marvin Minsky veröffentlichten Arbeiten, die für die Computermusik relevant sind. Simon und Sumner (1968) beschreiben eine formale Mustersprache für Musik sowie eine Methode zur Musterinduktion, um mehr oder weniger implizite Muster in Musikstücken zu entdecken. Ein Beispiel für ein Muster, das entdeckt werden kann, ist: „Der Eröffnungsabschnitt steht in C-Dur, es folgt ein Abschnitt in der Dominante und dann eine Rückkehr zur ursprünglichen Tonart.“ Obwohl das Programm nicht abgeschlossen wurde, ist es bemerkenswert, dass es eines der ersten war, das sich mit dem wichtigen Thema der Modellierung von Musik beschäftigte, ein Thema, das weithin untersucht wurde und immer noch wird. Die Verwendung von Modellen, die auf generativen Grammatiken basieren, war und ist beispielsweise ein wichtiger und sehr nützlicher Ansatz bei der Modellierung von Musik (Lerdahl und Jackendoff, 1983).

Marvin Minsky befasst sich in seinem bekannten Aufsatz „Music, Mind, and Meaning“ (1981) mit der wichtigen Frage, „wie Musik unseren Verstand beeindruckt“. Er wendet seine Konzepte des Agenten und seiner Rolle in einer Gesellschaft von Agenten als einen möglichen Ansatz an, um diese Frage zu erhellen. Er deutet zum Beispiel an, dass ein Akteur nichts weiter tun könnte, als zu bemerken, dass die Musik einen bestimmten Rhythmus hat. Andere Agenten könnten kleine musikalische Muster wahrnehmen, z. B. Wiederholungen einer Tonhöhe, Unterschiede wie die gleiche Tonfolge, die eine Quinte höher gespielt wird, und so weiter. Sein Ansatz berücksichtigt auch komplexere Beziehungen innerhalb eines Musikstücks, indem er Agenten höherer Ordnung einsetzt, die in der Lage sind, große Musikabschnitte zu erkennen. Es ist wichtig klarzustellen, dass Minsky in diesem Papier nicht versucht, den Leser von der Gültigkeit seines Ansatzes zu überzeugen, er deutet lediglich dessen Plausibilität an.

Unter den kompositorischen Systemen gibt es eine große Anzahl, die sich mit dem Problem der automatischen Harmonisierung unter Verwendung verschiedener KI-Techniken befassen. Eine der frühesten Arbeiten ist die von Rothgeb (1969). Er schrieb ein SNOBOL-Programm, um das Problem der Harmonisierung des unbezifferten Basses zu lösen (aus einer Folge von Bassnoten werden die Akkorde und Stimmführungen abgeleitet, die diese Bassnoten begleiten), und zwar mit Hilfe einer Reihe von Regeln wie: „Wenn der Bass eines Dreiklangs um einen Halbton abfällt, dann hat die nächste Bassnote eine Sexte.“ Das Hauptziel von Rothgeb war nicht die automatische Harmonisierung selbst, sondern die Überprüfung der rechnerischen Solidität von zwei Bassharmonisierungstheorien aus dem 18.

Eine der umfassendsten Arbeiten zur Harmonisierung ist die von Ebcioglu (1993). Er entwickelte ein Expertensystem, CHORAL, zur Harmonisierung von Chorälen im Stil von J. S. Bach. CHORAL erhält eine Melodie und erzeugt die entsprechende Harmonisierung anhand von heuristischen Regeln und Einschränkungen. Das System wurde mit einer vom Autor entwickelten logischen Programmiersprache implementiert. Ein wichtiger Aspekt dieser Arbeit ist die Verwendung von Mengen logischer Primitive zur Darstellung der verschiedenen Sichtweisen auf die Musik (Akkordansicht, Zeitscheibenansicht, melodische Ansicht usw.). Dies geschah, um das Problem der Darstellung großer Mengen komplexen musikalischen Wissens zu lösen.

MUSACT (Bharucha, 1993) verwendet neuronale Netze, um ein Modell der musikalischen Harmonie zu lernen. Es wurde entwickelt, um musikalische Intuitionen von harmonischen Qualitäten zu erfassen. Eine der Qualitäten eines Dominantakkords besteht beispielsweise darin, beim Hörer die Erwartung zu wecken, dass der Tonika-Akkord gleich erklingen wird. Je größer die Erwartung ist, desto größer ist das Gefühl der Konsonanz des Tonika-Akkords. Die Komponisten können diese Erwartungen in unterschiedlichem Maße erfüllen oder verletzen. MUSACT ist in der Lage, solche Qualitäten zu erlernen und abgestufte Erwartungshaltungen in einem gegebenen harmonischen Kontext zu erzeugen.

In HARMONET (Feulner, 1993) wird das Harmonisierungsproblem mit einer Kombination aus neuronalen Netzen und Techniken zur Erfüllung von Beschränkungen angegangen. Das neuronale Netz lernt die so genannte harmonische Funktionalität der Akkorde (Akkorde können die Funktion der Tonika, der Dominante, der Subdominante usw. übernehmen), und die inneren Stimmen der Akkorde werden mit Hilfe von Beschränkungen gefüllt. Die Arbeit an HARMONET wurde durch das MELONET-System erweitert (Hörnel und Degenhardt, 1997; Hörnel und Menzel, 1998). MELONET verwendet ein neuronales Netz, um eine höhere Struktur in melodischen Sequenzen zu lernen und zu reproduzieren. Ausgehend von einer Melodie erfindet das System eine barocke Harmonisierung und Variation einer beliebigen Choralstimme. Nach Ansicht der Autoren bilden HARMONET und MELONET zusammen ein leistungsfähiges Musikkompositionssystem, das Variationen erzeugt, die in ihrer Qualität denen eines erfahrenen menschlichen Organisten ähneln.

Pachet und Roy (1998) setzten für die Harmonisierung auch Constraint-Satisfaction-Techniken ein. Diese Techniken nutzen die Tatsache, dass sowohl die Melodie als auch das Harmonisierungswissen den möglichen Akkorden Beschränkungen auferlegen. Ein Problem bei reinen Constraint-Satisfaction-Ansätzen ist jedoch die Effizienz.

In Sabater et al. (1998) wird das Problem der Harmonisierung mit einer Kombination aus Regeln und fallbasierter Argumentation angegangen. Dieser Ansatz beruht auf der Beobachtung, dass eine rein regelbasierte Harmonisierung in der Regel scheitert, weil im Allgemeinen „nicht die Regeln die Musik machen, sondern die Musik die Regeln“. Warum sollte man sich also nicht auf die Quelle der Regeln, d. h. auf die Kompositionen selbst, stützen, anstatt sich nur auf eine Reihe unvollkommener Regeln zu verlassen? Die fallbasierte Argumentation ermöglicht die Verwendung von Beispielen bereits harmonisierter Kompositionen als Fälle für neue Harmonisierungen. Das System harmonisiert eine gegebene Melodie, indem es zunächst nach ähnlichen, bereits harmonisierten Fällen sucht; wenn dies nicht gelingt, sucht es nach anwendbaren allgemeinen Harmonieregeln. Wenn keine Regel anwendbar ist, schlägt das System fehl und kehrt zum vorherigen Entscheidungspunkt zurück. Die Experimente haben gezeigt, dass die Kombination von Regeln und Fällen zu viel weniger Fehlschlägen bei der Suche nach einer geeigneten Harmonisierung führt als die Verwendung einer der beiden Techniken allein. Ein weiterer Vorteil des fallbasierten Ansatzes besteht darin, dass jedes neu korrekt harmonisierte Stück gespeichert und als neues Beispiel für die Harmonisierung anderer Melodien zur Verfügung gestellt werden kann, d. h. es findet ein Lernprozess statt. Je mehr Beispiele dem System zur Verfügung stehen, desto seltener muss das System auf die Regeln zurückgreifen und scheitert daher seltener. MUSE (Schwanauer, 1993) ist ebenfalls ein lernendes System, das einen anfänglich kleinen Satz von Beschränkungen für die Stimmführung erweitert, indem es einen Satz von Regeln für Stimmverdopplung und Stimmführung lernt. Es lernt, indem es die Regelagenda neu ordnet und die Regeln, die den Satz der Stimmführungsbeschränkungen erfüllen, in Gruppen einteilt. MUSE lernte erfolgreich einige der Standardregeln für die Stimmführung, die in traditionellen Büchern für tonale Musik enthalten sind.

Morales-Manzanares et al. (2001) entwickelten ein System namens SICIB, das in der Lage ist, Musik mit Hilfe von Körperbewegungen zu komponieren. Dieses System verwendet Daten von Sensoren, die am Tänzer angebracht sind, und wendet Inferenzregeln an, um die Gesten in Echtzeit mit der Musik zu verbinden.

Synthese von ausdrucksstarker Musik

Eine der Hauptbeschränkungen von computergenerierter Musik ist ihre mangelnde Ausdruckskraft, d. h. ihr Mangel an „Gestik“. Als Gestik bezeichnen Musiker die Nuancen der Darbietung, die einzigartig und subtil interpretierend oder, mit anderen Worten, kreativ sind.

Einer der ersten Versuche, sich mit der Ausdruckskraft in der Musik zu befassen, stammt von Johnson (1992). Sie entwickelte ein Expertensystem zur Bestimmung des Tempos und der Artikulation, die beim Spielen von Bachs Fugen aus dem Wohltemperierten Klavier anzuwenden sind. Die Regeln wurden von zwei erfahrenen menschlichen Interpreten erstellt. Die Ausgabe enthält den Basis-Tempowert und eine Liste von Aufführungsanweisungen zu Notendauer und Artikulation, die von einem menschlichen Spieler befolgt werden sollten. Die Ergebnisse stimmen weitgehend mit den Anweisungen überein, die in den bekannten kommentierten Ausgaben des „Wohltemperierten Klaviers“ gegeben werden. Die größte Einschränkung dieses Systems ist seine mangelnde Allgemeingültigkeit, da es nur für Fugen im 4/4-Takt gut funktioniert. Für andere Metren sollten die Regeln anders sein. Eine weitere offensichtliche Folge dieses Mangels an Allgemeinheit ist, dass die Regeln nur auf Bach-Fugen anwendbar sind.

Die Arbeit der KTH-Gruppe aus Stockholm (Friberg, 1995; Friberg et al., 1998, 2000; Bresin, 2001) ist eine der bekanntesten langfristigen Bemühungen um Aufführungssysteme. Ihr aktuelles System Director Musices enthält Regeln für Tempo, Dynamik und Artikulationsveränderungen, die an MIDI gebunden sind. Diese Regeln werden sowohl aus theoretischem musikalischem Wissen als auch durch Training abgeleitet, insbesondere durch den sogenannten Analyse-durch-Synthese-Ansatz. Die Regeln sind in drei Hauptklassen unterteilt: Differenzierungsregeln, die die Unterschiede zwischen Skalentönen hervorheben; Gruppierungsregeln, die zeigen, welche Töne zusammengehören; und Ensemble-Regeln, die die verschiedenen Stimmen eines Ensembles synchronisieren.

Canazza et al. (1997) haben ein System entwickelt, um zu analysieren, wie sich die Ausdrucksabsichten des Musikers in der Darbietung widerspiegeln. Die Analyse zeigt zwei verschiedene Ausdrucksdimensionen auf: die eine bezieht sich auf die Energie (Dynamik) und die andere auf die Kinetik (Rubato) des Stücks. Die Autoren haben auch ein Programm entwickelt, mit dem ausdrucksstarke Darbietungen entsprechend diesen beiden Dimensionen erzeugt werden können.

Die Arbeit von Dannenberg und Derenyi (1998) ist ebenfalls ein gutes Beispiel für Artikulationstransformationen unter Verwendung manuell erstellter Regeln. Sie entwickelten einen Trompeten-Synthesizer, der ein physikalisches Modell mit einem Performance-Modell kombiniert. Das Ziel des Performancemodells ist die Generierung von Steuerinformationen für das physikalische Modell mit Hilfe einer Sammlung von Regeln, die manuell aus der Analyse einer Sammlung von kontrollierten Aufnahmen menschlicher Darbietung gewonnen wurden.

Ein weiterer Ansatz für die Transformation von Tempo und Dynamik ist die Verwendung neuronaler Netztechniken. In Bresin (1998) wird ein System implementiert, das symbolische Entscheid30.9.2020ungsregeln mit neuronalen Netzen kombiniert, um den Stil echter Klavierspieler zu simulieren. Die Ausgaben der neuronalen Netze drücken Zeit- und Lautstärkeabweichungen aus. Diese neuronalen Netze erweitern das standardmäßige Feed-Forward-Netz, das mit dem Backpropagation-Algorithmus trainiert wurde, um Rückkopplungsverbindungen zwischen den Ausgangsneuronen und den Eingangsneuronen. Wir sehen, dass mit Ausnahme der Arbeit der KTH-Gruppe, die drei Ausdrucksmittel berücksichtigt, die anderen Systeme auf zwei Mittel beschränkt sind, wie Rubato und Dynamik oder Rubato und Artikulation. Diese Beschränkung hat mit der Verwendung von Regeln zu tun. Das Hauptproblem bei den regelbasierten Ansätzen ist nämlich, dass es sehr schwierig ist, Regeln zu finden, die allgemein genug sind, um die Vielfalt in verschiedenen Aufführungen desselben Stücks durch denselben Musiker und sogar die Vielfalt innerhalb einer einzigen Aufführung zu erfassen (Kendall und Carterette, 1990). Außerdem stehen die verschiedenen Ausdrucksmittel in Wechselwirkung zueinander. Das heißt, die Regeln für die Dynamik allein ändern sich, wenn auch das Rubato berücksichtigt wird. Es liegt auf der Hand, dass es aufgrund dieser Interdependenz umso schwieriger ist, die geeigneten Regeln zu finden, je mehr Ausdrucksmittel man zu modellieren versucht.

Wir haben ein fallbasiertes Argumentationssystem namens SaxEx (Arcos et al., 1998) entwickelt, ein Computerprogramm, das in der Lage ist, qualitativ hochwertige ausdrucksstarke Tenorsaxophon-Solodarbietungen von Jazzballaden zu synthetisieren, und zwar auf der Grundlage von Fällen, die menschliche Solodarbietungen darstellen. Wie bereits erwähnt, konnten frühere regelbasierte Ansätze zu diesem Problem nicht mit mehr als zwei Ausdrucksparametern (wie Dynamik und Rubato) umgehen, weil es zu schwierig ist, Regeln zu finden, die allgemein genug sind, um die Vielfalt ausdrucksstarker Darbietungen zu erfassen. Außerdem interagieren die verschiedenen Ausdrucksparameter miteinander, was es noch schwieriger macht, geeignete Regeln zu finden, die diese Interaktionen berücksichtigen.

Wir haben gezeigt, dass es möglich ist, die fünf wichtigsten Ausdrucksparameter – Dynamik, Rubato, Vibrato, Artikulation und Anschlag der Noten – mit Hilfe von fallbasiertem Denken zu behandeln. Zu diesem Zweck verwendet SaxEx einen Fallspeicher mit Beispielen menschlicher Darbietungen, die mit Hilfe von Spektralmodellierungstechniken und musikalischem Hintergrundwissen analysiert wurden. Die Partitur des aufzuführenden Stücks wird dem System ebenfalls zur Verfügung gestellt. Der Kern der Methode besteht darin, jede eingegCebene Note zu analysieren und (mit Hilfe des musikalischen Hintergrundwissens) ihre Rolle in der musikalischen Phrase, zu der sie gehört, zu bestimmen, Noten mit ähnlichen Rollen zu identifizieren und abzurufen (aus der Falldatenbank menschlicher Darbietungen) und schließlich die eingegebene Note so umzuwandeln, dass ihre Ausdruckseigenschaften (Dynamik, Rubato, Vibrato, Artikulation und Anschlag) denen der ähnlichsten abgerufenen Note entsprechen. Jede Note in der Falldatenbank wird mit ihrer Rolle in der musikalischen Phrase, zu der sie gehört, sowie mit ihren Ausdruckswerten kommentiert. Außerdem enthalten die Fälle nicht nur Informationen zu jeder einzelnen Note, sondern auch kontextuelles Wissen auf Phrasenebene. Daher haben die Fälle in diesem System eine komplexe, objektzentrierte Darstellung.

Obwohl die Ergebnisse auf monophone Darbietungen beschränkt sind, sind sie sehr überzeugend und zeigen, dass fallbasiertes Schließen eine sehr leistungsfähige Methode ist, um das Wissen eines menschlichen Interpreten, das in seinen Spielbeispielen implizit enthalten ist, direkt zu nutzen, anstatt zu versuchen, dieses Wissen mit Hilfe von Regeln explizit zu machen. Einige Audioergebnisse können hier angehört werden. Neuere Arbeiten (Arcos und López de Mántaras, 2001; López de Mántaras und Arcos, 2002, López de Mántaras und Arcos, 2012) beschreiben dieses System sehr detailliert.

Basierend auf der Arbeit an SaxEx haben wir TempoExpress (Grachten et al., 2004) entwickelt, ein fallbasiertes Argumentationssystem zur Anwendung musikalisch akzeptabler Tempotransformationen auf monophone Audioaufnahmen musikalischer Darbietungen. TempoExpress verfügt über eine reichhaltige Beschreibung der musikalischen Expressivität der Darbietungen, die nicht nur zeitliche Abweichungen der gespielten Partiturnoten umfasst, sondern auch strengere Arten der Expressivität, wie z. B. Notenverzierungen, Konsolidierung und Fragmentierung, darstellt. Bei der Tempotransformation wird die Expressivität der Darbietung so angepasst, dass das Ergebnis für das neue Tempo natürlich klingt. Anhand einer Fallstudie mit bereits gespielten Melodien wird die angemessene Expressivität ermittelt. Das Problem, das Tempo einer musikalischen Darbietung zu ändern, ist nicht so trivial, wie es scheinen mag, da es eine Menge musikalisches Wissen und kreatives Denken erfordert. Wenn ein Musiker ein Musikstück in verschiedenen Tempi aufführt, sind die Darbietungen nicht einfach nur zeitlich gestaffelte Versionen voneinander (als ob dieselbe Darbietung in verschiedenen Geschwindigkeiten wiedergegeben würde). Zusammen mit den Tempowechseln werden auch Variationen im musikalischen Ausdruck vorgenommen (Desain und Honing, 1993). Solche Variationen betreffen nicht nur das Timing der Noten, sondern können beispielsweise auch das Hinzufügen oder Weglassen von Verzierungen oder die Konsolidierung/Fragmentierung von Noten beinhalten. Neben dem Tempo scheinen auch andere bereichsspezifische Faktoren eine wichtige Rolle bei der Art und Weise zu spielen, wie eine Melodie vorgetragen wird, wie z. B. das Metrum und die Phrasenstruktur. Die Tempotransformation gehört zu den Aufgaben der manuellen Nachbearbeitung in Audiolabors. Die Automatisierung dieses Prozesses könnte daher von industriellem Interesse sein.

Andere Anwendungen von Case-based Reasoning auf ausdrucksstarke Musik sind die von Suzuki et al. (1999) sowie von Tobudic und Widmer (2003, 2004). Suzuki et al. (1999) verwenden Fallbeispiele für ausdrucksstarke Darbietungen, um mehrere Darbietungen eines bestimmten Stücks mit unterschiedlichem musikalischem Ausdruck zu generieren; sie befassen sich jedoch nur mit zwei ausdrucksstarken Parametern. Tobudic und Widmer (2003) wenden Instance-Based Learning auch auf das Problem der Generierung ausdrucksstarker Aufführungen an. Ihr Ansatz wird verwendet, um ein regelbasiertes Modell auf Notenebene mit einer gewissen Vorhersagefähigkeit auf der höheren Ebene der musikalischen Phrasierung zu ergänzen. Konkret erkennt die Komponente des instanzbasierten Lernens Aufführungsmuster eines Konzertpianisten auf Phrasenebene und lernt, wie sie analog auf neue Stücke angewendet werden können. Der Ansatz lieferte einige interessante Ergebnisse, war aber, wie die Autoren einräumen, aufgrund der Beschränkung auf die Verwendung einer Attribut-Wert-Darstellung für die Phrasen nicht sehr überzeugend. Eine solche einfache Darstellung kann relevante strukturelle Informationen des Stücks nicht berücksichtigen, weder auf der Ebene der Unterphrasen noch auf der Ebene der Phrasen untereinander. In einer späteren Arbeit gelang es Tobudic und Widmer (2004), diese Einschränkung durch die Verwendung einer relationalen Phrasendarstellung teilweise zu überwinden.

Widmer et al. (2009) beschreiben ein Computerprogramm, das lernt, klassische Klaviermusik ausdrucksvoll zu spielen. Der Ansatz ist datenintensiv und basiert auf statistischem Lernen. Die ausdrucksstarke Darbietung von Musik erfordert sicherlich ein hohes Maß an Kreativität, aber die Autoren nehmen eine sehr pragmatische Haltung zu der Frage ein, ob ihr Programm als kreativ bezeichnet werden kann oder nicht, und behaupten, dass „Kreativität im Auge des Betrachters liegt“. Tatsächlich besteht das Hauptziel der Autoren darin, das Musizieren als kreatives menschliches Verhalten mit Hilfe von KI-Methoden zu untersuchen und besser zu verstehen.

Die Möglichkeit für einen Computer, ausdrucksstark zu spielen, ist ein grundlegender Bestandteil der so genannten Hyper-Instrumente. Dabei handelt es sich um Instrumente, die den Klang eines Instruments mit so eigenwilligen Nuancen anreichern, dass er menschliche Ausdruckskraft und einen reichen, lebendigen Klang erhält. Um ein Hyperinstrument zu bauen, nimmt man ein traditionelles Instrument, z. B. ein Cello, und schließt es über elektronische Sensoren im Hals und im Bogen an einen Computer an; außerdem stattet man die Hand, die den Bogen hält, mit Sensoren aus und programmiert den Computer mit einem System ähnlich SaxEx, das eine Analyse der Art und Weise ermöglicht, wie der Mensch das Stück interpretiert, und zwar auf der Grundlage der Partitur, der musikalischen Kenntnisse und der Messwerte der Sensoren. Die Ergebnisse einer solchen Analyse ermöglichen es dem Hyperinstrument, eine aktive Rolle zu spielen und Aspekte wie Klangfarbe, Ton, Rhythmus und Phrasierung zu verändern sowie eine Begleitstimme zu erzeugen. Mit anderen Worten: Sie haben ein Instrument, das sein eigener intelligenter Begleiter sein kann. Tod Machover vom Media Lab des MIT hat ein solches Hypercello entwickelt, und der große Cellist Yo-Yo Ma spielte auf dem Hypercello ein von Tod Machover komponiertes Stück namens „Begin Again Again…“, das vor einigen Jahren beim Tanglewood Festival uraufgeführt wurde.

Computerkreativität und improvisierte Musik

Die Musikimprovisation ist ein sehr komplexer kreativer Prozess, der auch computergestützt modelliert worden ist. Sie wird oft als „fliegende Komposition“ bezeichnet und ist daher kreativ gesehen komplexer als Komposition und wahrscheinlich die komplexeste der drei hier untersuchten musikalischen Aktivitäten. Ein frühes Werk zur Computerimprovisation ist das Flavors-Band-System von Fry (1984). Flavors Band ist eine prozedurale, in LISP eingebettete Sprache zur Spezifikation von Jazz- und Popmusikstilen. Ihre prozedurale Darstellung ermöglicht die Erzeugung von Partituren in einem vorgegebenen Stil durch Änderungen an einer als Eingabe gegebenen Partiturspezifikation. Es ermöglicht die Kombination von Zufallsfunktionen und musikalischen Einschränkungen (Akkorde, Modi usw.), um improvisatorische Variationen zu erzeugen. Das bemerkenswerteste Ergebnis von Flavors Band war ein interessantes Arrangement der Basslinie und ein improvisiertes Solo der Komposition „Giant Steps“ von John Coltrane.

GenJam (Biles, 1994) stellt ein Modell eines Jazzmusikers dar, der mit Hilfe eines genetischen Algorithmus improvisieren lernt. Ein menschlicher Zuhörer spielt die Rolle der Fitnessfunktion, indem er die Improvisationen der Nachkommen bewertet. Papadopoulos und Wiggins (1998) verwendeten ebenfalls einen genetischen Algorithmus, um Jazzmelodien über eine vorgegebene Akkordfolge zu improvisieren. Im Gegensatz zu GenJam enthält das Programm eine Fitnessfunktion, die automatisch die Qualität der Improvisationen der Nachkommen bewertet, indem sie acht verschiedene Aspekte der improvisierten Melodie bewertet, wie z. B. die melodische Kontur, die Dauer der Noten, die Abstände zwischen den Noten und so weiter.

Franklin (2001) verwendet rekurrente neuronale Netze, um anhand von Transkriptionen von Solo-Improvisationen des Jazz-Saxophonisten Sonny Rollins zu lernen, wie man Jazz-Soli improvisiert. Ein Algorithmus des verstärkenden Lernens wird verwendet, um das Verhalten des neuronalen Netzes zu verfeinern. Die Belohnungsfunktion bewertet die Solos des Systems nach Kriterien der Jazz-Harmonie und nach dem Stil von Rollins.

Die fehlende Interaktivität mit einem menschlichen Improvisator bei den oben genannten Ansätzen wurde kritisiert (Thom, 2001) mit der Begründung, dass sie den Musiker von der physischen und spontanen Erschaffung einer Melodie entfernen. Es stimmt zwar, dass das grundlegendste Merkmal der Improvisation das spontane Erzeugen einer Melodie in Echtzeit ist, aber es stimmt auch, dass Interaktivität bei diesen Ansätzen nicht beabsichtigt war und sie dennoch sehr interessante Improvisationen hervorbringen können. Thom (2001) widmet sich mit ihrem System Band-out-of-a-Box (BoB) dem Problem der interaktiven Echtzeit-Improvisation zwischen BoB und einem menschlichen Spieler. Mit anderen Worten: BoB ist ein „Musikbegleiter“ für Echtzeit-Improvisation. Thoms Ansatz folgt der psychologischen Theorie der Jazzimprovisation von Johnson-Laird (1991). Diese Theorie wendet sich gegen die Ansicht, dass Improvisation aus dem Neuarrangieren und Umwandeln von im Gedächtnis gebliebenen „Licks“ unter den Zwängen einer Harmonie besteht. Johnson-Laird schlägt stattdessen ein stochastisches Modell vor, das auf einer gierigen Suche in einem begrenzten Raum möglicher Noten zu einem bestimmten Zeitpunkt beruht. Der sehr wichtige Beitrag von Thom besteht darin, dass ihr System diese Beschränkungen und damit das stochastische Modell vom menschlichen Spieler mit Hilfe eines unüberwachten probabilistischen Clustering-Algorithmus lernt. Das gelernte Modell wird verwendet, um Soli in benutzerspezifische Spielweisen zu abstrahieren. Die Parameter dieses gelernten Modells werden dann in einen stochastischen Prozess integriert, der die Soli als Reaktion auf viertaktige Soli des menschlichen Improvisators erzeugt. BoB wurde sehr erfolgreich evaluiert, indem seine Echtzeit-Solos in zwei verschiedenen Stilen getestet wurden, dem des Saxophonisten Charlie Parker und dem des Geigers Stephane Grapelli.

Ein weiteres bemerkenswertes interaktives Improvisationssystem wurde von Dannenberg (1993) entwickelt. Der Unterschied zu Thoms Ansatz besteht darin, dass in Dannenbergs System die Musikerzeugung hauptsächlich von den Zielen des Komponisten und nicht von den Zielen des Interpreten bestimmt wird. Das interaktive Improvisationssystem von Wessel (1998) ist dem von Thom insofern näher, als es ebenfalls die Begleitung und Verbesserung von Live-Improvisationen betont.

Computerkreativität und KI in der bildenden Kunst

AARON ist ein über viele Jahre von dem Künstler und Programmierer Harold Cohen (Cohen, 1995) entwickeltes Robotersystem, das mit seinem Roboterarm einen Pinsel aufnehmen und selbstständig auf eine Leinwand malen kann. Er zeichnet Menschen in einem botanischen Garten, wobei er nicht nur eine Kopie einer bestehenden Zeichnung anfertigt, sondern so viele einzigartige Zeichnungen zu diesem Thema erstellt, wie von ihm verlangt werden können. AARON hat noch nie einen Menschen gesehen und ist auch noch nie durch einen botanischen Garten gelaufen, sondern hat durch Regeln Wissen über Körperhaltungen und Pflanzen erhalten.

Das Wissen von AARON und die Art und Weise, wie AARON sein Wissen nutzt, ist nicht vergleichbar mit dem Wissen, das wir Menschen haben und nutzen, denn menschliches Wissen basiert auf der Erfahrung der Welt, und Menschen erfahren die Welt mit ihrem Körper, ihrem Gehirn und ihrem Fortpflanzungssystem, was Computer nicht haben. Aber genau wie bei den Menschen hat AARONs Wissen kumulativ erworben. Sobald es zum Beispiel das Konzept eines Blattbüschels verstanden hat, kann es auf dieses Wissen zurückgreifen, wann immer es es braucht. Pflanzen existieren für AARON in Bezug auf ihre Größe, die Dicke der Gliedmaßen im Verhältnis zur Höhe, die Geschwindigkeit, mit der die Gliedmaßen im Verhältnis zur Ausdehnung dünner werden, den Grad der Verzweigung, die Winkelausdehnung, in der die Verzweigung auftritt, und so weiter.

Ähnliche Prinzipien gelten für die Bildung von Blättern und Blattbüscheln. Durch Manipulation dieser Faktoren ist AARON in der Lage, eine breite Palette von Pflanzentypen zu erzeugen und wird nie zweimal dieselbe Pflanze zeichnen, selbst wenn es eine Reihe von Pflanzen zeichnet, die erkennbar demselben Typ angehören. Außerdem muss AARON wissen, woraus der menschliche Körper besteht, was die verschiedenen Teile sind und wie groß sie im Verhältnis zueinander sind. Dann muss es wissen, wie die Körperteile gelenkig miteinander verbunden sind und welche Bewegungsarten und -bereiche es für jedes Gelenk gibt. Da ein sich kohärent bewegender Körper nicht einfach nur eine Ansammlung sich unabhängig voneinander bewegender Teile ist, muss AARON auch etwas darüber wissen, wie die Bewegungen des Körpers koordiniert werden: was der Körper zum Beispiel tun muss, um sein Gleichgewicht zu halten. Konzeptionell ist dies nicht so schwierig, wie es scheinen mag, zumindest für stehende Positionen mit einem oder beiden Füßen auf dem Boden.

Es geht nur darum, den Schwerpunkt über der Basis zu halten und gegebenenfalls die Arme einzusetzen, um eine ausgewogene Position zu erreichen. AARON weiß, dass normale Menschen zwei Arme und zwei Beine haben, und wird daher immer zwei Gliedmaßen zeichnen, wenn sie nicht verdeckt sind. Das bedeutet, dass AARON keine Regeln „brechen“ kann und sich niemals die Möglichkeit vorstellen kann, Menschen mit nur einem Bein zu zeichnen, oder andere Formen der Abstraktion. In diesem Sinne ist AARONs Kreativität begrenzt und sehr weit von der eines Menschen entfernt. Dennoch wurden AARONs Bilder in der Londoner Tate Modern und im San Francisco Museum of Modern Art ausgestellt. In gewisser Hinsicht besteht AARON also eine Art kreativen Turing-Test, denn seine Werke sind gut genug, um neben einigen der besten menschlichen Künstler ausgestellt zu werden.

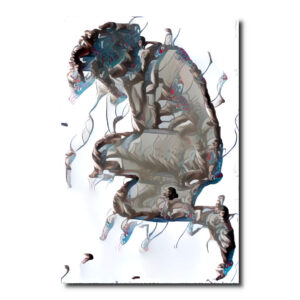

Mit der Software „The Painting Fool“ erstellte Kunstwerke.

Computerkreativität und Painting Fool

Das Programm Painting Fool von Simon Colton (Colton et al., 2015) ist viel autonomer als AARON. Obwohl die Software nicht physisch Farbe auf die Leinwand aufträgt, simuliert sie viele Stile digital, von der Collage bis zum Pinselstrich. In Coltons Worten:

The Painting Fool braucht nur minimale Anweisungen und kann seine eigenen Konzepte entwickeln, indem er im Internet nach Quellenmaterial sucht. Die Software führt eigene Websuchen durch und durchforstet Websites sozialer Medien. Die Idee ist, dass dieser Ansatz es ermöglicht, Kunst zu produzieren, die für das Publikum bedeutungsvoll ist, weil sie im Wesentlichen auf die menschliche Erfahrung zurückgreift, wie wir im Internet handeln, fühlen und argumentieren.

Die Software führt eigene Websuchen durch und durchforstet Websites sozialer Medien. Die Idee ist, dass dieser Ansatz es ermöglicht, Kunst zu produzieren, die für das Publikum bedeutungsvoll ist, weil sie im Wesentlichen auf die menschliche Erfahrung zurückgreift, wie wir im Internet handeln, fühlen und argumentieren.

Simon Colton (Colton et al., 2015)

So produzierte der Painting Fool 2009 seine eigene Interpretation des Krieges in Afghanistan, die auf einer Nachrichtenmeldung basierte. Das Ergebnis ist eine Gegenüberstellung von afghanischen Bürgern, Explosionen und Kriegsgräbern.

Weitere Beispiele für die Anwendung computergestützter Kreativität auf die Malerei und andere visuelle Künste sind die Arbeiten von Karl Sims und Jon McCormack. Karl Sims‘ Reaction-Diffusion Media Wall (Sims, 2016) basiert auf der interaktiven Simulation von Chemikalien, die reagieren und diffundieren, um entsprechend den Reaktions-Diffusions-Gleichungen, die die biologische Morphogenese steuern, neue dynamische Muster zu erzeugen. Dieses Werk ist im Museum of Science in Boston ausgestellt. Zu den früheren Arbeiten von Karl Sims gehört die Anwendung evolutionärer Berechnungsmethoden auf interaktiv entwickelte Bilder in seinem System Genetic Images (Sims, 1994).

Auch Jon McCormack untersucht in seinem „Design After Nature Project“ (McCormack, 2014), wie biologische Prozesse erfolgreich auf kreative Systeme angewandt werden können. In einem anderen Projekt, „Creative Ecosystems“, untersucht er Konzepte und Metaphern aus biologischen Ökosystemen (McCormack und d’Inverno, 2012) als Mittel zur Förderung der menschlichen Kreativität in der digitalen Kunst.

Es gibt zahlreiche weitere Beispiele aus dem Bereich der visuellen Künste. Die genannten Beispiele sind nicht nur repräsentativ, sondern meiner Meinung nach auch die wichtigsten Beiträge zu diesem Bereich.

Hier wagen wir zu widersprechen (Anm.: 😉 ).

Unterstützung und Förderung der menschlichen Kreativität: Die Demokratisierung der Kreativität

Können wir künstliche Intelligenz nutzen, um menschliche Kreativität und Entdeckungen zu unterstützen? Ein neuer Trend, der als „Assisted Creation“ bekannt ist, hat wichtige Auswirkungen auf die Kreativität: Einerseits machen unterstützende Kreativitätssysteme ein breites Spektrum kreativer Fähigkeiten zugänglicher. Andererseits erleichtern kollaborative Plattformen, wie die im Rahmen des europäischen Projekts PRAISE zum Erlernen von Musik (Yee-King und d’Inverno, 2014) entwickelte, das Erlernen neuer kreativer Fähigkeiten. PRAISE ist eine auf einem sozialen Netzwerk basierende Lernplattform, die Menschen und intelligente Software-Agent*innen umfasst, die einer Musikstudent*in Feedback zu Komposition, Arrangement und Performance geben. Die Schüler*innen laden ihre Lösungen zu einem vorgegebenen Unterrichtsplan hoch, der von einer Tutor*in bereitgestellt wird (Kompositionen, Arrangements oder Aufführungen). Dann analysieren die intelligenten Agent*innen sowie andere Kommilitonen und Tutor*innen diese Lösungen und geben Feedback. Im Falle einer Komposition könnte die Agent*in zum Beispiel sagen: „Deine Modulation klingt ziemlich gut, aber du könntest versuchen, in den Takten 5 bis 8 alles um eine große Terz nach oben zu modulieren.“

Andere intelligente Software-Agent*innen vergleichen die Darbietungen der Schüler*innen mit denen, die die Tutor*in zuvor beim Hochladen des Unterrichtsplans aufgezeichnet hat. Eine Kamera erfasst die Gesten der Schüler*in, und die Software-Agent*innen geben auch Rückmeldungen über mögliche Fehlhaltungen. Tools wie dieses, die den Erwerb von Fähigkeiten beschleunigen, führen zu einem Phänomen, das als „Demokratisierung der Kreativität“ bekannt ist.

Bereits 1962 schrieb Douglas Engelbart (Engelbart, 1962) über eine „Schreibmaschine, die es Ihnen erlauben würde, einen neuen Prozess des Verfassens von Texten anzuwenden […] Sie können Ihre neuen Ideen leichter integrieren und so Ihre Kreativität kontinuierlicher nutzen.“ Bei Engelbarts Vision ging es nicht nur um die Steigerung der individuellen Kreativität. Er wollte auch die kollektive Intelligenz und Kreativität von Gruppen steigern, indem er die Zusammenarbeit und die Problemlösungsfähigkeit von Gruppen verbesserte. Ein Grundgedanke dabei ist, dass Kreativität ein sozialer Prozess ist, der durch Technologie unterstützt werden kann. Wenn wir diese Ideen in die Zukunft projizieren, können wir uns eine Welt vorstellen, in der Kreativität leicht zugänglich ist und (fast) jeder auf dem Niveau der besten Schriftsteller*innen schreiben, wie die großen Meister*innen malen, hochwertige Musik komponieren und sogar neue Formen des kreativen Ausdrucks entdecken kann. Für eine Person, die keine besonderen kreativen Fähigkeiten besitzt, ist die Erlangung einer neuen Fähigkeit durch unterstützte Kreativitätssysteme sehr befähigend.

Obwohl das oben beschriebene futuristische Szenario derzeit reine Fiktion ist, gibt es bereits mehrere Beispiele für unterstützte Kreation. Eines der interessantesten ist das am Georgia Institute of Technology entwickelte System für unterstütztes Schlagzeugspielen (Bretan und Weinberg, 2016). Es besteht aus einer tragbaren robotischen Gliedmaße, die es Schlagzeugern ermöglicht, mit drei Armen zu spielen. Der 61 Zentimeter lange „intelligente Arm“ kann an der Schulter des Musikers befestigt werden. Er reagiert auf menschliche Gesten und die Musik, die er hört. Wenn der Schlagzeuger beispielsweise das High-Hat-Becken spielt, bewegt sich der Roboterarm, um das Ride-Becken zu spielen. Wenn der Schlagzeuger zur Snare wechselt, schaltet der mechanische Arm auf das Tom um.

Ein weiteres sehr interessantes Ergebnis im Bereich der unterstützten Kreativität ist die Übertragung von Musikstilen und Harmonien von Genre zu Genre, die im SONY Computer Science Lab in Paris entwickelt wurde (Martin et al., 2015; Papadopoulos et al., 2016) und Komponist*innen bei der Harmonisierung eines Musikstücks eines Genres entsprechend dem Stil eines anderen, völlig anderen Genres unterstützt. Zum Beispiel die Harmonisierung eines Jazzstandards im Stil von Mozart.

Abschließende Bemerkungen: Scheinbar oder wirklich kreativ?

Margaret Boden wies darauf hin, dass ein künstlich intelligenter Computer, selbst wenn er so kreativ wäre wie Bach oder Einstein, für viele nur scheinbar kreativ, aber nicht wirklich kreativ sein würde. Ich stimme ihr aus zwei Gründen voll und ganz zu: die fehlende Intentionalität und unsere Abneigung, künstlich intelligenten Agent*innen einen Platz in unserer Gesellschaft zu geben. Das Fehlen von Intentionalität ist eine direkte Folge von Searles „Chinese Room“-Argument (Searle, 1980), das besagt, dass Computerprogramme nur eine syntaktische Manipulation von Symbolen vornehmen können, aber nicht in der Lage sind, ihnen eine Semantik zu geben. Es ist allgemein anerkannt, dass Intentionalität durch kausale Beziehungen erklärt werden kann. Es ist jedoch auch wahr, dass bestehenden Computerprogrammen zu viele relevante kausale Verbindungen fehlen, um Intentionalität zu zeigen, aber vielleicht werden zukünftige, möglicherweise anthropomorphe, „verkörperte“ künstliche Intelligenzen, d. h. Agent*innen, die nicht nur mit hochentwickelter Software, sondern auch mit verschiedenen Arten fortschrittlicher Sensoren ausgestattet sind, die ihnen eine Interaktion mit der Umwelt ermöglichen, über genügend kausale Verbindungen verfügen, um Symbolen Bedeutung zu verleihen und Intentionalität zu haben.

Was die soziale Ablehnung betrifft, so zögern wir deshalb so sehr zu akzeptieren, dass nichtbiologische Agenten kreativ sein können (sogar biologische, wie im Fall von „Nonja“, einer zwanzigjährigen Malerin aus Wien, deren abstrakte Gemälde in Kunstgalerien ausgestellt und geschätzt wurden, aber sobald bekannt wurde, dass sie ein Orang-Utan aus dem Wiener Zoo war, wurde ihre Arbeit viel weniger geschätzt!), weil sie keinen natürlichen Platz in unserer menschlichen Gesellschaft haben und eine Entscheidung, sie zu akzeptieren, wichtige soziale Auswirkungen hätte. Es ist daher viel einfacher zu sagen, dass sie intelligent, kreativ usw. zu sein scheinen, anstatt zu sagen, dass sie es sind. Mit einem Wort, es handelt sich um eine moralische, nicht um eine wissenschaftliche Frage. Ein dritter Grund für die Ablehnung der Kreativität von Computerprogrammen ist, dass sie sich ihrer Leistungen nicht bewusst sind. Es stimmt zwar, dass Maschinen kein Bewusstsein haben und möglicherweise nie bewusst denken werden, aber das fehlende Bewusstsein ist kein wesentlicher Grund, ihnen das Potenzial für Kreativität oder gar Intelligenz abzusprechen. Schließlich wären Computer nicht das erste Beispiel für unbewusste Schöpfer*innen; die Evolution ist das erste Beispiel, wie Stephen Jay Gould (1996) brillant darlegt: „Wenn die Schöpfung eine visionär Schöpfer*in erfordert, wie schafft es dann die blinde Evolution, so großartige neue Dinge wie uns zu schaffen?“

Danksagungen

Diese Forschung wurde teilweise durch den Zuschuss 2014-SGR-118 der Generalitat de Catalunya unterstützt.

Dieser Post wurde automatisiert durch die Medienkunstarbeit „Meine Krake heißt Klothilde“ von Hidéo SNES erzeugt und gegendert.

Poster Galerie Wien

Repost von BBVA OpenMind | Autor*in: Ramón López de Mántaras | <date undisclosed> | Automatisch übersetzt durch www.deepl.com

Ausgewählte Bibliographie

— Bharucha, J. 1993. “MUSACT: A connectionist model of musical harmony.” In Machine Models of Music, S. M. Schwanauer and D. A. Levitt (eds.). Cambridge, MA: The MIT Press, 497–509.

— Boden, M. 1987. Artificial Intelligence and Natural Man. New York: Basic Books.

— Boden, M. 1991. The Creative Mind: Myths and Mechanisms. New York: Basic Books.

— Boden, M. (ed.) 1994. Dimensions of Creativity Cambridge, MA: The MIT Press.

— Boden, M. 2009. “Computers models of creativity.” AI Magazine 30(3): 23–34.

— Bresin, R. 2001. “Articulation rules for automatic music performance.” In Proceedings of the 2001 International Computer Music Conference. San Francisco: International Computer Music Association.

— Bretan, M., and Weinberg, G. 2016. “A survey of robotic musicianship.” Commun. ACM 59(5): 100–109.

— Cope, D. 1987. “Experiments in music intelligence.” In Proceedings of the 1987 International Computer Music Conference. San Francisco: International Computer Music Association.

— Cope, D. 1990. “Pattern matching as an engine for the computer simulation of musical style.” In Proceedings of the 1990 International Computer Music Conference. San Francisco: International Computer Music Association.

— Ebcioglu, K. 1993. “An expert system for harmonizing four-part chorales.” In Machine Models of Music, S. M. Schwanauer and D. A. Levitt (eds.). Cambridge, MA: The MIT Press, 385–401.

— Friberg, A., Bresin, R., Fryden, L., and Sunberg, J. 1998. “Musical punctuation on the microlevel: automatic identification and performance of small melodic units.” Journal of New Music Research 27(3): 271–292.

— Gould, S. J. 1996. “Creating the creators.” Discover Magazine October: 42–54.

— Hörnel, D., and Degenhardt, P. 1997. “A neural organist improvising Baroque-style melodic variations.” In Proceedings of the 1997 International Computer Music Conference. San Francisco: International Computer Music Association, 430–433.

— Johnson, M. L. 1992. “An expert system for the articulation of Bach fugue melodies.” In Readings in Computer Generated Music, D. L. Baggi (ed.). Los Alamitos, CA: IEEE Press, 41–51.

— Johnson-Laird, P. N. 1991. “Jazz improvisation: A theory at the computational level.” In Representing Musical Structure, P. Howell, R. West, and I. Cross (eds.). London: Academic Press.

— Lerdahl, F., and Jackendoff, R. 1983. “An overview of hierarchical structure in music.” Music

Perception 1: 229–252.

— López de Mántaras, R., and Arcos, J. L. 2002. “AI and music: From composition to expressive performance.” AI Magazine 23(3): 43–57.

— López de Mántaras, and R., Arcos J. L. 2012. “Playing with cases: Rendering expressive music with case-based reasoning.” AI Magazine 33(4): 22–31.

— Martín, D., Frantz, B., and Pachet, F. 2015. “Improving music composition through peer feedback: Experiment and preliminary results.” In Music Learning with Massive Open Online Courses (MOOCs), Luc Steels (ed.). Amsterdam: Ios Press, 195–204.

— McCormack, J., and d’Inverno, M. 2012. Computers and Creativity. Heidelberg: Springer.

— Moorer, J. A. 1972. “Music and computer composition.” Reprinted in Machine Models of Music, S. M. Schwanauer and D. A. Levitt (eds.). Cambridge, MA: The MIT Press, 1993, 167–186.

— Pachet, F., and Roy, P. 1998. “Formulating constraint satisfaction problems on part-whole relations: The case of automatic harmonization.” In ECAI’98 Workshop on Constraint Techniques for Artistic Applications. Brighton, UK.

— Partridge, D., and Rowe, J. 1994. Computers and Creativity. Bristol: Intellect Books.

— Ritchie, G. D. 2009. “Can computers create humour.” AI Magazine 30(3): 71–81.

— Sabater, J., Arcos, J. L., and López de Mántaras, R. 1998. “Using rules to support case-based reasoning for harmonizing melodies.” In AAAI Spring Symposium on Multimodal Reasoning. Menlo Park, CA: American Association for Artificial Intelligence, 147–151.

— Searle, J. 1980. “Minds, brains and programs.” Behavioral and Brain Sciences 3(3): 417–457.

— Simon, H. A., Sumner, R. K. 1968. “Patterns in music.” Reprinted in Machine Models of Music, S. M. Schwanauer and D. A. Levitt (eds.). Cambridge, MA: The MIT Press, 83–110.

— Sims, K. 2016. “Reaction-diffusion media wall.” http://www.karlsims.com/rd-exhibit.html.

— Suzuki, T., Tokunaga, T., and Tanaka, H. 1999. “A case-based approach to the generation of musical expression.” In Proceedings of the 16th International Joint Conference on Artificial Intelligence. Burlington, MA: Morgan Kaufmann, 642–648.

— Turing, A. M. 1950. “Computing machinery and intelligence.” Mind LIX(236): 433–460.

— Widmer, G., Flossmann, S., and Grachten, M. 2009. “YQX plays Chopin.” AI Magazine 30(3): 35–48.